在构建基于Spark的电商推荐系统时,主要可以分为以下三个步骤:1、数据收集与预处理;2、模型训练与评估;3、推荐系统部署与优化。以下是详细的描述。

一、数据收集与预处理

构建推荐系统的第一步是收集和预处理数据。数据的质量和丰富程度直接影响推荐系统的效果。

-

数据收集:从各种渠道收集用户行为数据,包括用户的点击、浏览、购买等行为数据,以及用户和商品的基本信息数据。

-

数据清洗:处理数据中的缺失值、异常值,保证数据的准确性和完整性。

-

特征工程:提取用户和商品的特征,包括用户的偏好、商品的属性等,增加数据的维度和丰富度。

-

数据分割:将数据分成训练集、验证集和测试集,确保模型训练和评估的公正性。

数据预处理的具体步骤:

- 数据清洗:删除或修正缺失值、重复值和异常值。

- 数据转换:将原始数据转换成适合模型输入的数据格式,如将类别数据转换成数值数据。

- 特征提取:提取用户行为特征和商品属性特征,如用户的点击次数、购买次数、商品的价格、类别等。

- 数据标准化:对数值数据进行归一化处理,保证数据的尺度一致性。

- 数据分割:将数据分成训练集、验证集和测试集,通常按照7:2:1的比例进行分割。

二、模型训练与评估

在数据预处理完成后,接下来就是训练推荐模型并对其进行评估。

-

选择模型:根据推荐系统的需求选择合适的模型,如协同过滤、矩阵分解、深度学习等。

-

模型训练:使用预处理后的数据训练模型,调整模型参数,提升模型的性能。

-

模型评估:使用验证集和测试集评估模型的效果,常用的评估指标有准确率、召回率、F1值等。

模型选择与训练的具体步骤:

- 选择推荐算法:根据业务需求选择合适的推荐算法,如基于用户的协同过滤、基于物品的协同过滤、矩阵分解、隐语义模型等。

- 模型训练:使用Spark的MLlib库训练推荐模型,调整模型的超参数,如学习率、迭代次数、正则化参数等。

- 模型评估:使用验证集和测试集评估模型的性能,常用的评估指标有RMSE、MAE、Precision、Recall、F1-score等。

三、推荐系统部署与优化

模型训练完成后,接下来就是将推荐系统部署到生产环境中,并进行持续优化。

-

系统部署:将训练好的模型部署到生产环境中,提供实时的推荐服务。

-

实时更新:定期更新推荐模型,保证推荐结果的时效性和准确性。

-

效果监控:对推荐系统的效果进行监控,收集用户反馈,及时调整推荐策略。

-

持续优化:根据用户反馈和业务需求,不断优化推荐系统,提高推荐效果。

推荐系统部署与优化的具体步骤:

- 系统部署:将训练好的模型保存为可序列化的格式,并部署到生产环境中,集成到电商平台的推荐服务中。

- 实时更新:定期更新推荐模型,如每周或每月重新训练模型,保证推荐结果的时效性和准确性。

- 效果监控:对推荐系统的效果进行监控,收集用户反馈,如点击率、转化率、用户满意度等,及时调整推荐策略。

- 持续优化:根据用户反馈和业务需求,不断优化推荐系统,如引入新的推荐算法、增加数据源、优化特征工程等。

总结与建议

构建基于Spark的电商推荐系统需要经过数据收集与预处理、模型训练与评估、推荐系统部署与优化三个步骤。在数据收集与预处理中,需要保证数据的质量和丰富程度;在模型训练与评估中,需要选择合适的推荐算法,并对模型进行评估和调整;在推荐系统部署与优化中,需要保证推荐结果的时效性和准确性,并不断优化推荐系统。

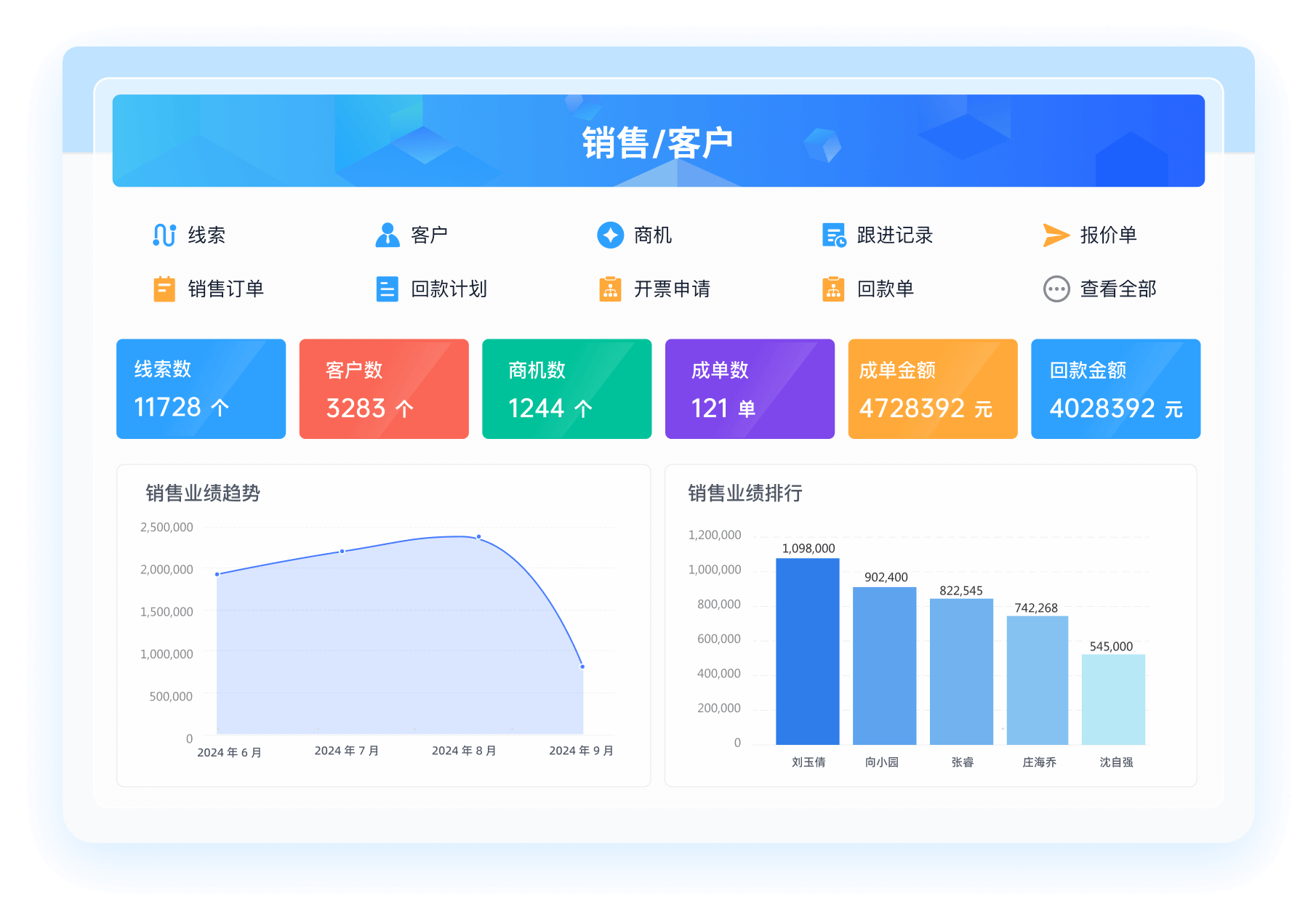

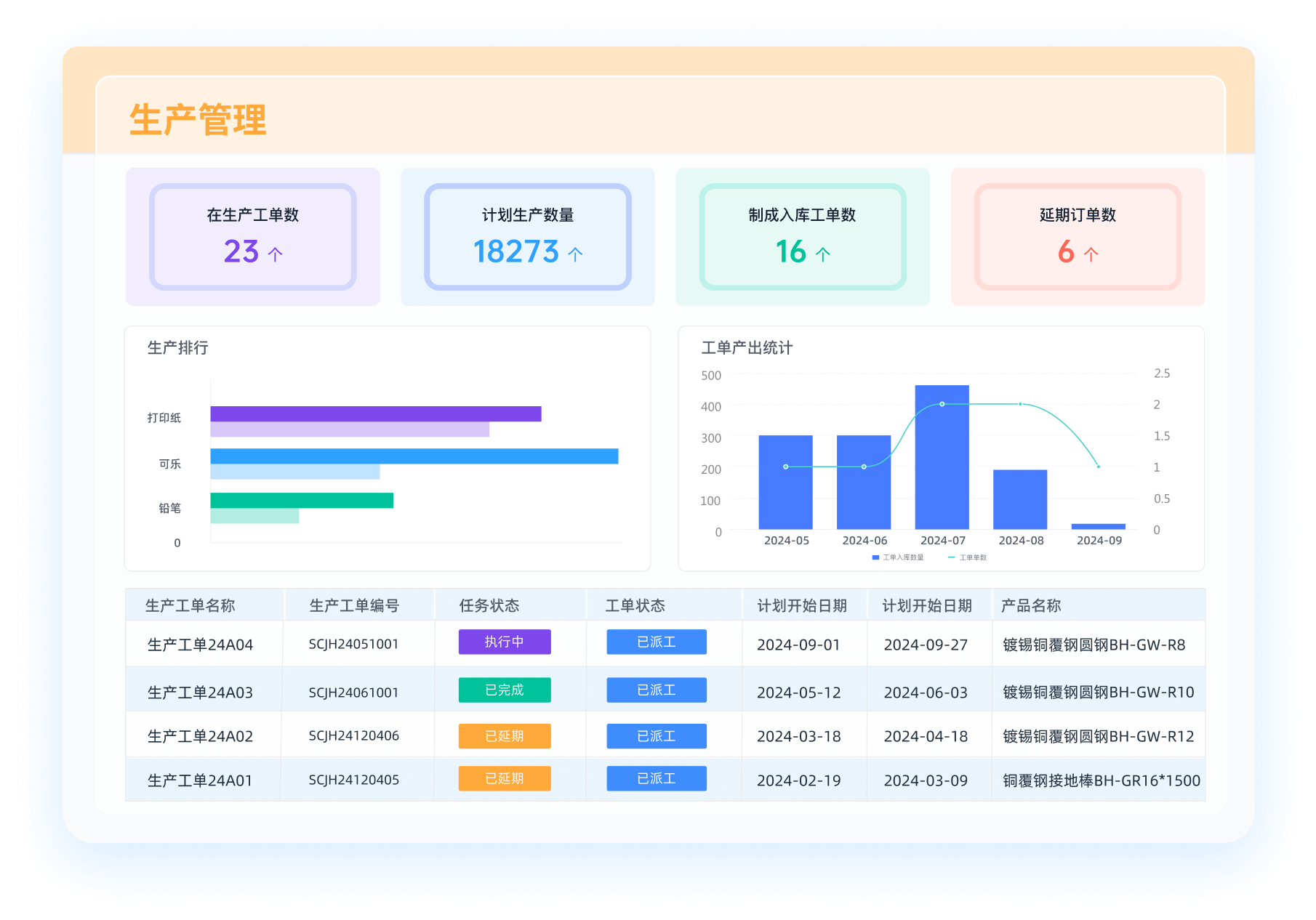

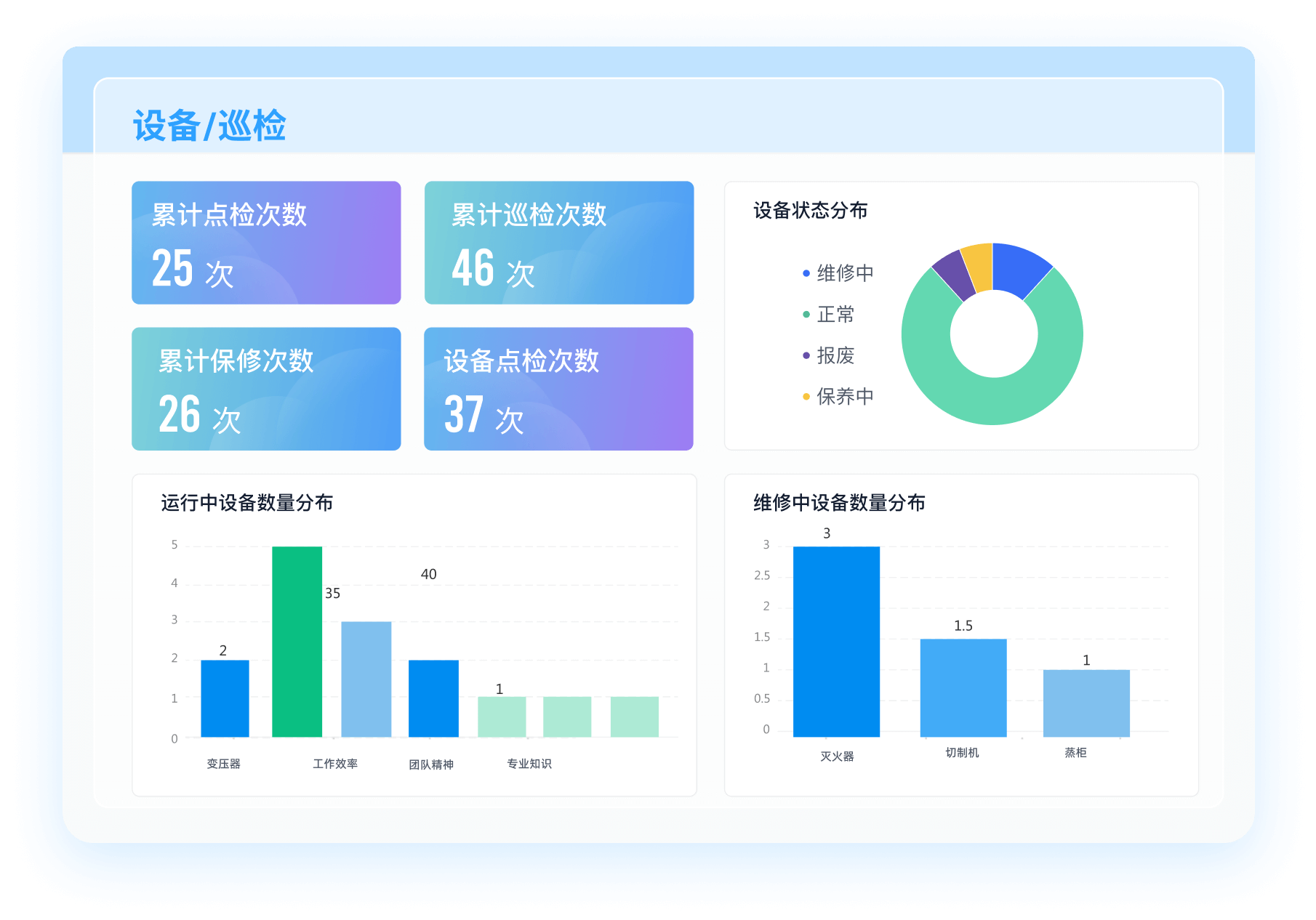

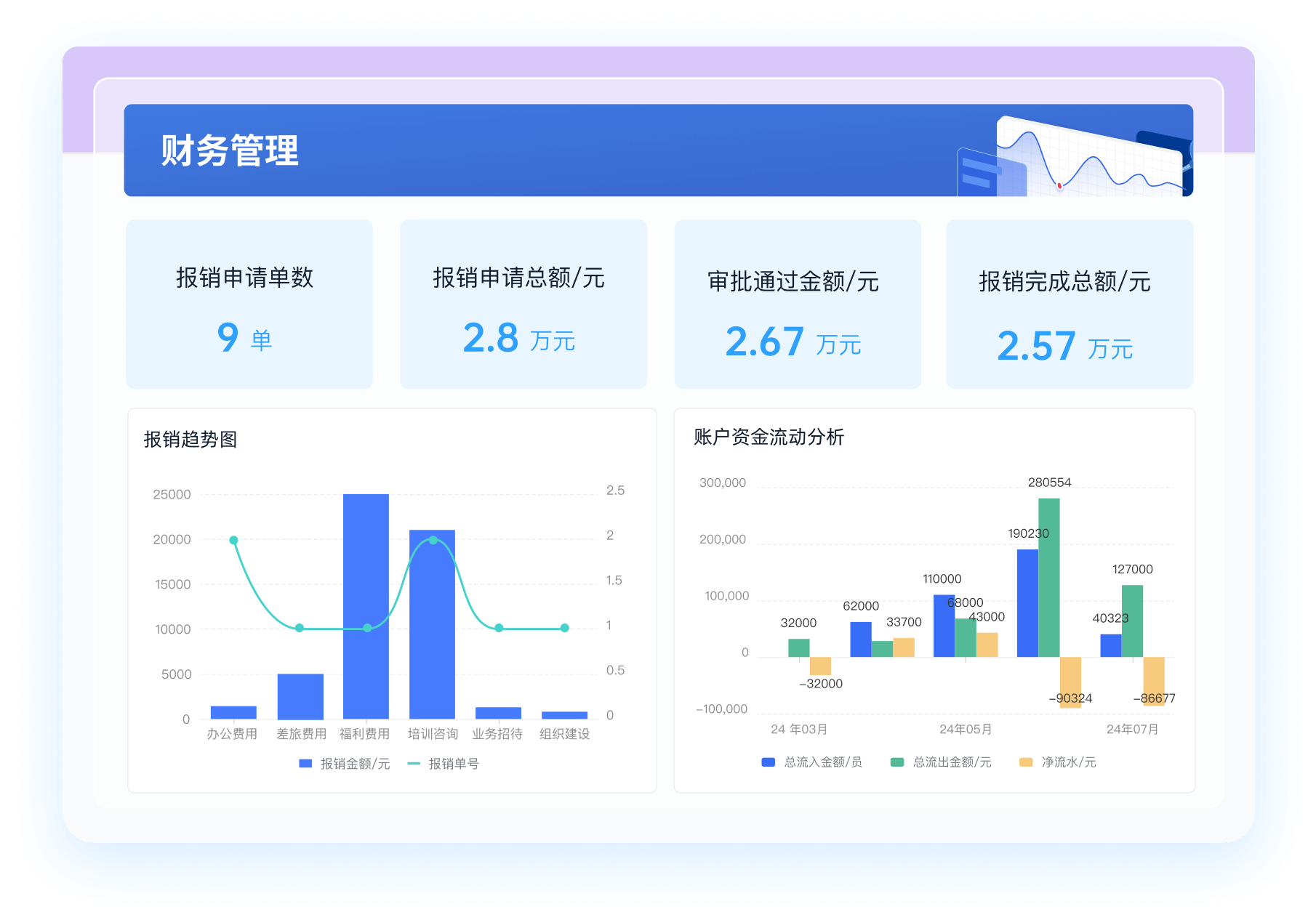

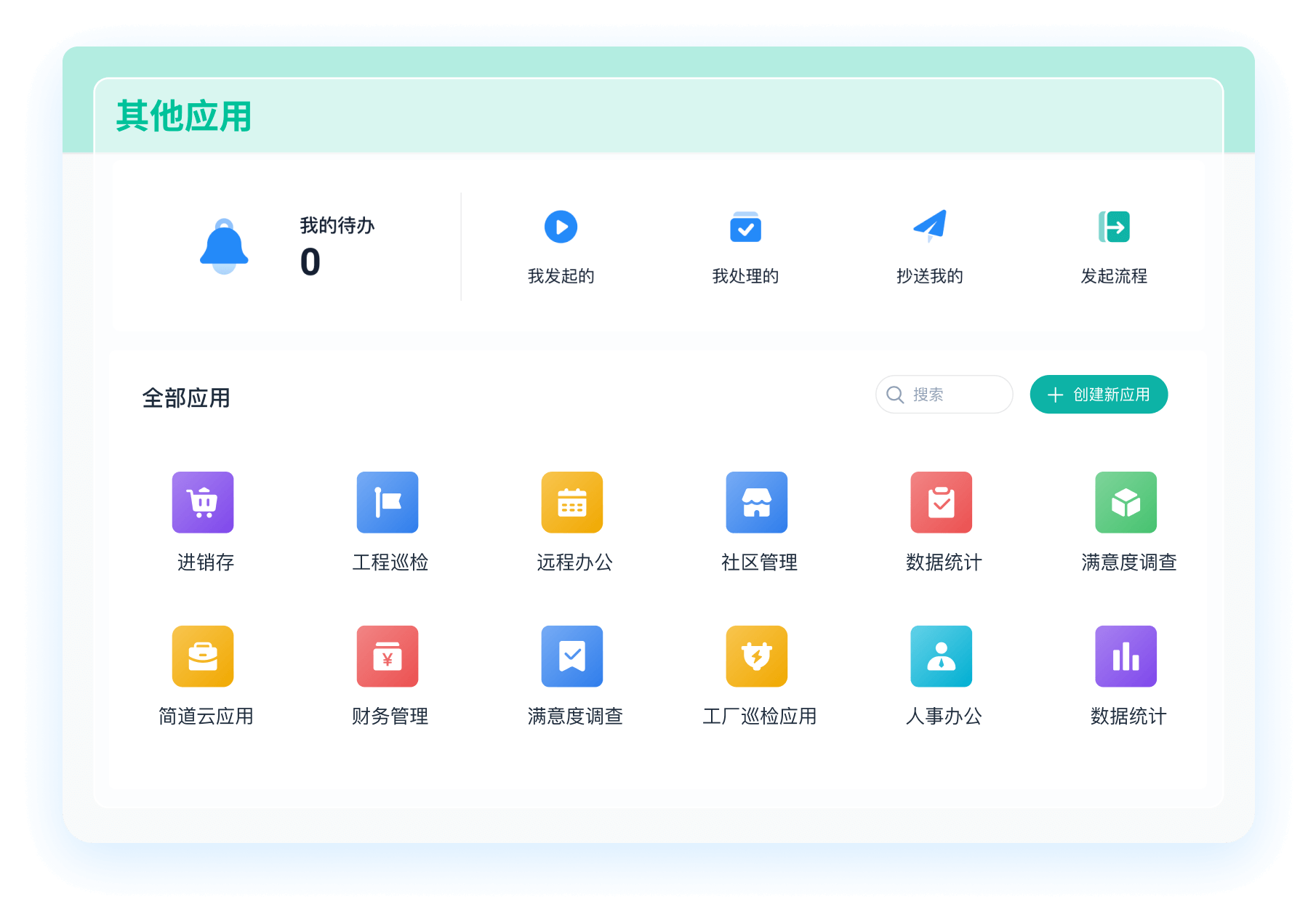

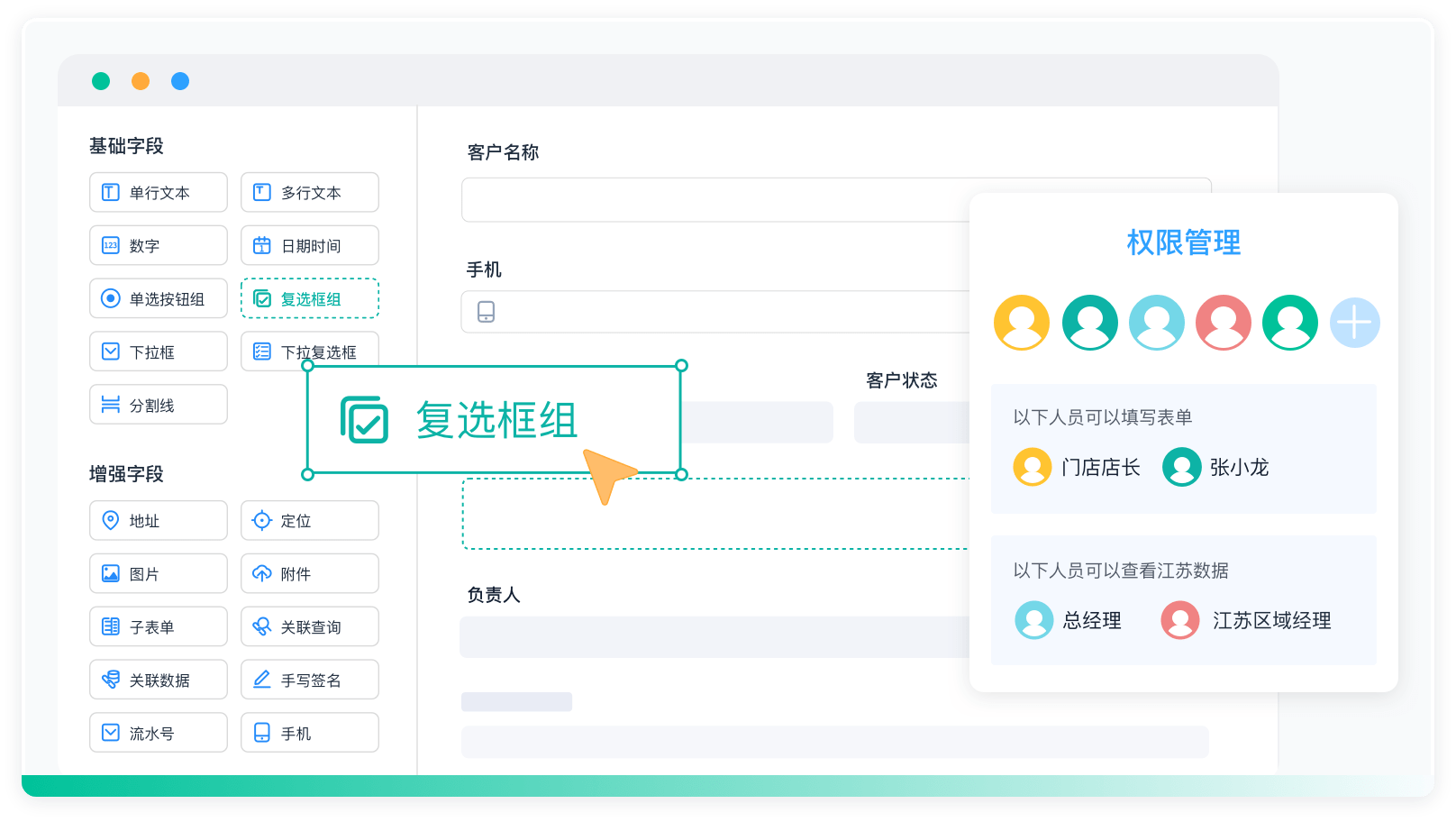

为了更好地理解和应用这些步骤,可以参考简道云的财务管理模板,了解如何通过低代码、零代码开发快速构建企业业务管理软件,提升业务管理效率。简道云财务管理模板: https://s.fanruan.com/kw0y5;

相关问答FAQs:

1. 什么是基于Spark的电商推荐系统?

基于Spark的电商推荐系统是一种利用Apache Spark大数据处理框架构建的推荐引擎,旨在为用户提供个性化的产品推荐。这种系统通常会分析用户的历史行为数据,包括浏览记录、购买历史和评分信息,以生成精准的推荐列表。Spark的强大计算能力和高效的内存处理能力,使得即使在海量数据的情况下,也能快速地进行数据分析和模型训练。

电商推荐系统的核心是通过机器学习算法来预测用户对未见过商品的偏好。常用的推荐算法包括协同过滤、内容推荐和混合推荐等。通过这些算法,系统能够实时调整推荐结果,以适应用户的变化需求。

2. 如何使用Spark构建电商推荐系统的第一步?

构建基于Spark的电商推荐系统的第一步是数据收集和预处理。这一过程包括以下几个关键环节:

-

数据收集:从多个数据源(如网站日志、用户行为数据、产品信息等)收集相关数据。为了保证推荐系统的有效性,收集的数据应覆盖广泛的用户行为和产品特征。

-

数据清洗:在收集到的数据中,往往会存在噪音和不完整的信息。数据清洗的过程包括去除重复数据、填补缺失值以及删除不相关的特征。这一步骤对于提高模型的训练效果至关重要。

-

特征工程:对清洗后的数据进行特征提取和转换,以便更好地服务于推荐算法。特征工程的步骤可能包括对用户行为进行编码、构建用户和产品的特征向量等。通过这些操作,可以将原始数据转化为适合机器学习模型输入的格式。

在这一阶段,使用Spark的DataFrame和RDD(弹性分布式数据集)可以帮助处理海量数据。利用Spark的分布式计算能力,可以大大加快数据处理速度,为后续的模型训练打下基础。

3. 在构建基于Spark的电商推荐系统时,如何选择和训练模型?

模型选择和训练是构建电商推荐系统的关键步骤,涉及到选择合适的推荐算法和训练模型以达到最佳效果。以下是一些常用的方法和注意事项:

-

选择推荐算法:根据业务需求和数据特点选择合适的推荐算法。常见的推荐算法有:

- 协同过滤:基于用户或物品的相似性进行推荐,适合用户行为数据丰富的场景。

- 内容推荐:根据物品的特征进行推荐,适合物品信息丰富的场景。

- 混合推荐:结合协同过滤和内容推荐的优点,提供更全面的推荐结果。

-

模型训练:在Spark中,可以使用MLlib(Spark的机器学习库)来训练推荐模型。对于协同过滤算法,可以使用ALS(交替最小二乘法)进行矩阵分解,以生成用户和物品的隐向量表示。

-

超参数调优:在训练模型过程中,需要对超参数进行调优,以优化模型性能。可以通过交叉验证等方法来评估不同超参数组合下模型的表现。

-

模型评估:使用准确率、召回率、F1分数等指标对模型进行评估。通过这些指标,可以了解模型在推荐任务中的效果,并据此进行进一步的优化和调整。

通过以上步骤,可以有效地构建一个基于Spark的电商推荐系统。值得注意的是,推荐系统的构建是一个持续迭代的过程,需要根据用户反馈和市场变化不断调整和优化模型。

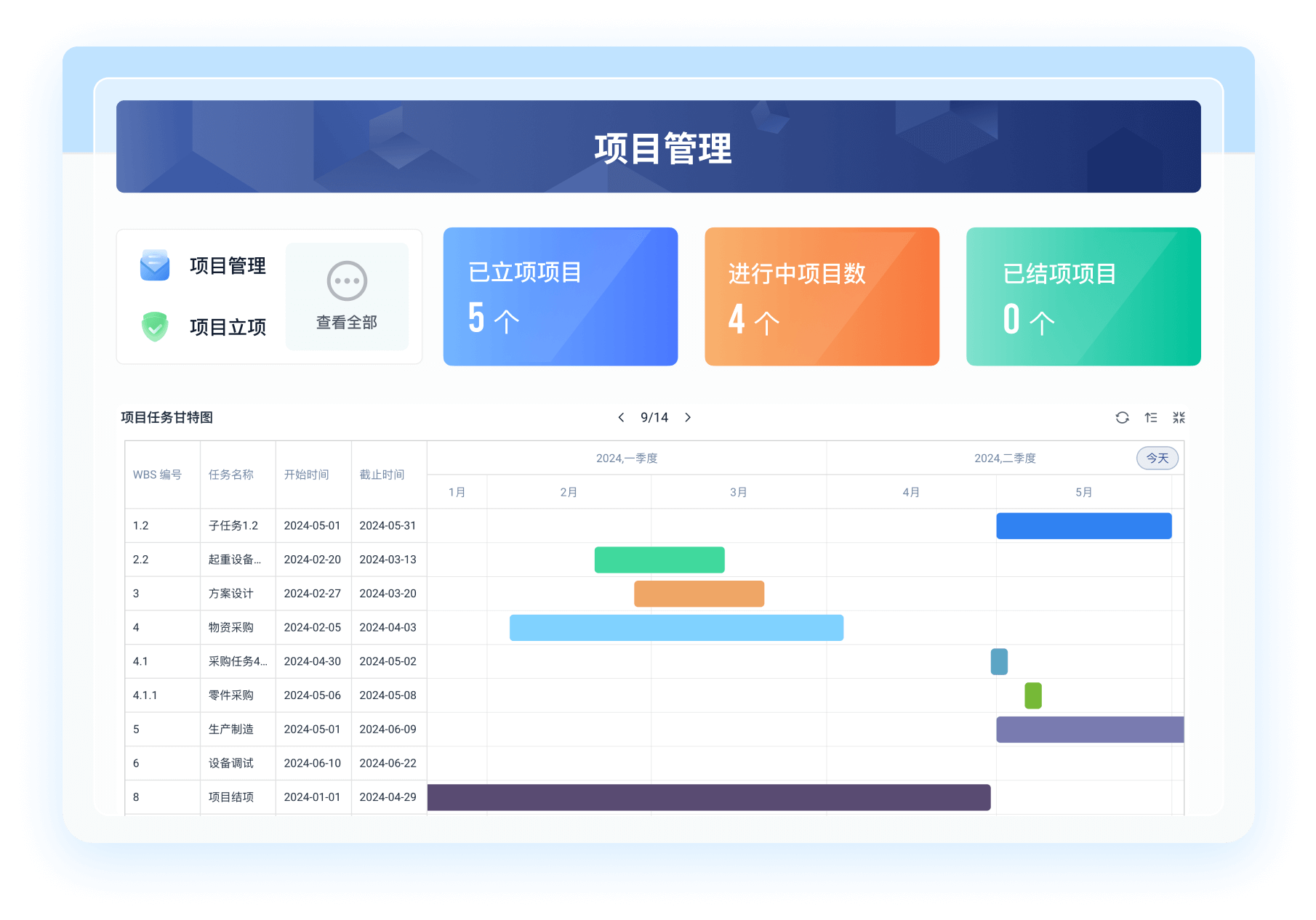

在这个过程中,我们公司使用了一些项目管理软件的模板,以帮助团队更好地协作和管理项目进度。你可以参考我们的项目管理软件模板,直接使用或根据实际需求进行自主修改: https://s.fanruan.com/kw0y5;。

阅读时间:9 分钟

阅读时间:9 分钟  浏览量:150次

浏览量:150次

《零代码开发知识图谱》

《零代码开发知识图谱》

《零代码

新动能》案例集

《零代码

新动能》案例集

《企业零代码系统搭建指南》

《企业零代码系统搭建指南》